ジェスチャ認識

ジェスチャ認識(ジェスチャにんしき、英語: Gesture recognition)は、数学アルゴリズムを介して人間のジェスチャを解釈することを目的としたコンピュータサイエンスと言語技術のテーマである[1]。これは、コンピュータビジョンの専門分野の下位区分。ジェスチャは、あらゆる体の動きや状態から発生する可能性があるが、通常は顔や手から発生する。この分野の現在の焦点には、顔からの感情認識と手のジェスチャ認識が含まれる。ユーザーは、簡単なジェスチャを使用して、デバイスに物理的に触れることなく、デバイスの制御または操作が可能。手話を解釈するためにカメラとコンピュータビジョンアルゴリズムを使用して多くのアプローチがなされてきた。姿勢、歩行、パソコンおよび人間の行動の識別と認識も、ジェスチャ認識技術の対象[2]。ジェスチャ認識は、人体の言語を理解する方法と見なすことができる。したがって、キーボードへの入力の大部分を制限するプリミティブテキストユーザインタフェースやGUI(グラフィカルユーザーインターフェイス)よりも、マシンと人間の間に豊かな架け橋を築くことができる。マウスを使用して、機械的なデバイスなしで自然に相互作用する。

概要

[編集]

ジェスチャ認識機能:

- より正確な

- 高い安定性

- デバイスのロックを解除するための時間の節約

ジェスチャ認識の主なアプリケーション:

- 自動車セクター

- 家庭用電化製品セクター

- トランジットセクター

- ゲーム部門

- スマートフォンのロック解除

- 防御[3]

- ホームオートメーション

- 手話の自動翻訳[4]

ジェスチャ認識は、コンピュータビジョンと画像処理の手法を使用して実行できる[5]。

文献には、コンピューターに接続されたカメラによるジェスチャまたはより一般的な人間のポーズや動きのキャプチャに関するコンピュータービジョン分野での進行中の作業が含まれる[6][7][8][9]。

ジェスチャ認識とペンコンピューティング:ペンコンピューティングは、システムのハードウェアへの影響を軽減し、キーボードやマウスなどの従来のデジタルオブジェクトを超えて、制御に使用できる物理的な世界のオブジェクトの範囲を拡大する。このような実装により、モニターを必要としない新しい範囲のハードウェアが可能になる。このアイデアは、ホログラフィックディスプレイの作成につながる可能性がある。ジェスチャ認識という用語は、グラフィックスタブレットでのインク、マルチタッチジェスチャ、マウスジェスチャ認識など、テキスト入力以外の手書き記号をより狭義に指すために使用される。これは、ポインティングデバイスカーソルを使用して記号を描画することによるコンピューターの相互作用[10][11][12]。(ペンコンピューティングを参照)

ジェスチャータイプ

[編集]コンピュータインターフェイスでは、2種類のジェスチャが区別される[13]。オンラインジェスチャを考慮する。これは、スケーリングや回転などの直接操作と見なすこともできる。対照的に、オフラインジェスチャは通常、インタラクションが終了した後に処理される。たとえば、コンテキストメニューをアクティブにするために円が描かれる。

- オフラインジェスチャ:ユーザーがオブジェクトを操作した後に処理されるジェスチャ。例として、メニューをアクティブにするジェスチャがある。

- オンラインジェスチャ:ダイレクトマニピュレーションジェスチャ。これらは、有形のオブジェクトを拡大縮小または回転するために使用される。

タッチレスインターフェース

[編集]タッチレスユーザーインターフェイスは、ジェスチャ制御に関連する新しいタイプのテクノロジー。タッチレスユーザーインターフェイス(TUI)は、キーボード、マウス、または画面に触れることなく、体の動きやジェスチャを介してコンピューターにコマンドを送信するプロセス[14]。ジェスチャコントロールに加えて、タッチレスインターフェイスは、デバイスに物理的に触れることなくデバイスと対話する機能を提供するため、広く普及している。

タッチレステクノロジーの種類

[編集]スマートフォン、ラップトップ、ゲーム、テレビ、音楽機器など、このタイプのインターフェイスを利用するデバイスは多数ある。

タッチレスインターフェイスの1つのタイプは、スマートフォンのBluetooth接続を使用して、企業の訪問者管理システムをアクティブにする。これにより、COVID-19パンデミックの際にインターフェースに直接触れる必要がなくなる[15]。

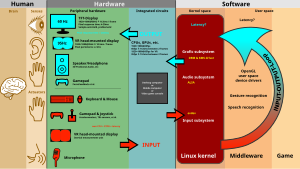

入力デバイス

[編集]人の動きを追跡し、実行している可能性のあるジェスチャを判別する機能は、さまざまなツールを使用して実現できる。キネティックユーザーインターフェイス(KUI)は、ユーザーがオブジェクトやボディの動きを通じてコンピューティングデバイスと対話できるようにするタイプのユーザーインターフェイス。KUIの例には、タンジブルユーザーインターフェイスや、WiiやMicrosoftのKinectなどのモーション対応ゲームやその他のインタラクティブプロジェクトが含まれる[16]。

画像/ビデオベースのジェスチャ認識では多くの研究が行われいるが、実装間で使用されるツールと環境にはいくつかの違いがある。

この別の例は、マウスジェスチャ追跡。この場合、マウスの動きは、ジェスチャを表すために時間の経過に伴う加速度の変化を調べることができる、人の手によって描かれる記号に関連付けられる[17][18][19]。このソフトウェアは、人間の震えや不注意な動きも補正する[20][21][22]。これらのスマート発光キューブのセンサーは、手や指、および近くにある他のオブジェクトを感知するために使用でき、データを処理するために使用できます。ほとんどのアプリケーションは音楽とサウンドの合成[23]が、他の分野にも適用できる。

関連項目

[編集]脚注

[編集]- ^ Kobylarz, Jhonatan; Bird, Jordan J.; Faria, Diego R.; Ribeiro, Eduardo Parente; Ekárt, Anikó (2020-03-07). “Thumbs up, thumbs down: non-verbal human-robot interaction through real-time EMG classification via inductive and supervised transductive transfer learning”. Journal of Ambient Intelligence and Humanized Computing (Springer Science and Business Media LLC) 11 (12): 6021–6031. doi:10.1007/s12652-020-01852-z. ISSN 1868-5137.

- ^ Matthias Rehm, Nikolaus Bee, Elisabeth André, Wave Like an Egyptian – Accelerometer Based Gesture Recognition for Culture Specific Interactions, British Computer Society, 2007

- ^ “Patent Landscape Report Hand Gesture Recognition PatSeer Pro” (英語). PatSeer 2017年11月2日閲覧。

- ^ Chai, Xiujuan, et al. "Sign language recognition and translation with kinect." IEEE Conf. on AFGR. Vol. 655. 2013.

- ^ Sultana A, Rajapuspha T (2012), "Vision Based Gesture Recognition for Alphabetical Hand Gestures Using the SVM Classifier", International Journal of Computer Science & Engineering Technology (IJCSET)., 2012

- ^ Pavlovic, V., Sharma, R. & Huang, T. (1997), "Visual interpretation of hand gestures for human-computer interaction: A review", IEEE Transactions on Pattern Analysis and Machine Intelligence, July, 1997. Vol. 19(7), pp. 677 -695.

- ^ R. Cipolla and A. Pentland, Computer Vision for Human-Machine Interaction, Cambridge University Press, 1998, ISBN 978-0-521-62253-0

- ^ Ying Wu and Thomas S. Huang, "Vision-Based Gesture Recognition: A Review" Archived 2011-08-25 at the Wayback Machine., In: Gesture-Based Communication in Human-Computer Interaction, Volume 1739 of Springer Lecture Notes in Computer Science, pages 103-115, 1999, ISBN 978-3-540-66935-7, doi:10.1007/3-540-46616-9

- ^ Alejandro Jaimes and Nicu Sebe, Multimodal human–computer interaction: A survey Archived 2011-06-06 at the Wayback Machine., Computer Vision and Image Understanding Volume 108, Issues 1-2, October–November 2007, Pages 116-134 Special Issue on Vision for Human-Computer Interaction, doi:10.1016/j.cviu.2006.10.019

- ^ Dopertchouk, Oleg; "Recognition of Handwriting Gestures", gamedev.net, January 9, 2004

- ^ Chen, Shijie; "Gesture Recognition Techniques in Handwriting Recognition Application", Frontiers in Handwriting Recognition p 142-147 November 2010

- ^ Balaji, R; Deepu, V; Madhvanath, Sriganesh; Prabhakaran, Jayasree "Handwritten Gesture Recognition for Gesture Keyboard" Archived 2008-09-06 at the Wayback Machine., Hewlett-Packard Laboratories

- ^ Dietrich Kammer, Mandy Keck, Georg Freitag, Markus Wacker, Taxonomy and Overview of Multi-touch Frameworks: Architecture, Scope and Features Archived 2011-01-25 at the Wayback Machine.

- ^ “touchless user interface Definition from PC Magazine Encyclopedia” (英語). pcmag.com. 2017年7月28日閲覧。

- ^ “The emerging need for touchless interaction technologies” (英語). ResearchGate. 2021年6月30日閲覧。

- ^ S. Benford; H. Schnadelbach; B. Koleva; B. Gaver; A. Schmidt; A. Boucher; A. Steed; R. Anastasi et al. (2003). Sensible, sensable and desirable: a framework for designing physical interfaces.

- ^ Per Malmestig, Sofie Sundberg, SignWiiver – implementation of sign language technology Archived 2008-12-25 at the Wayback Machine.

- ^ Thomas Schlomer, Benjamin Poppinga, Niels Henze, Susanne Boll, Gesture Recognition with a Wii Controller, Proceedings of the 2nd international Conference on Tangible and Embedded interaction, 2008

- ^ AiLive Inc., LiveMove White Paper Archived 2007-07-13 at the Wayback Machine., 2006

- ^ Electronic Design September 8, 2011. William Wong. Natural User Interface Employs Sensor Integration.

- ^ Cable & Satellite International September/October, 2011. Stephen Cousins. A view to a thrill.

- ^ TechJournal South January 7, 2008. Hillcrest Labs rings up $25M D round.

- ^ Percussa AudioCubes Blog October 4, 2012. Gestural Control in Sound Synthesis. Archived 2015-09-10 at the Wayback Machine.

外部リンク

[編集]- ジェスチャーとペンコンピューティングへの参照の注釈付き参考文献

- ペンベースコンピューティングの歴史に関するメモ(YouTube)

- 未来、それはすべてジェスチャーです—ジェスチャーインターフェースとビデオゲーム

- FordのGesturallyInteractive Advert —デジタルサイネージとのやり取りに使用されるジェスチャー

- 3Dハンドトラッキング—文献調査